9 этапов анализа контента сайта

9 этапов анализа контента сайта

На сегодняшний день наиболее современным приемом интернет-маркетинга специалисты считают анализирование сайта, выступающего в качестве конкурента, что позволяет создать ресурса на идентичную тематику, отличающийся лучшим качеством. Ниже речь пойдет о том, с какой периодичностью и каким образом производить анализ сайта, чтобы виртуальный ресурс обрел конкурентоспособность и стал популярным среди людей, использующих Интернет.

В каких ситуациях требуется анализ сайтов онлайн?

Контент сайта - это информация, содержащаяся на страницах виртуального ресурса. Анализ контента сайта предполагает проведение комплексной работы, направленной на выставление оценки структуры и информации, содержащейся на определенном ресурсе. Все это делается с точки зрения его внешней оптимизации. Идентичный принцип актуален, если речь идет об изучении сайта, принадлежащего конкурирующему предприятию. Если вы планируете оптимизировать Интернет-ресурс для поискового сервиса, тогда итоги анализа позволят вам подобрать оптимальные методы и направления для дальнейшей работы.

Как правило, анализировать сайт нужно при следующих обстоятельствах:

- виртуальный ресурс не позволяет добиться поставленной цели;

- основные задачи виртуального проекта разрешаются недостаточно быстро или не слишком эффективно;

- web-мастер испытывает сомнения насчет качества функционирования выбранной площадки;

- web-мастер испытывает необходимость в получении полной и актуальной информации, касающейся работы ресурса, который был им создан;

- в планы включается выполнение работы, направленной на оптимизацию ресурса (как внутреннюю, так и внешнюю);

- клиент испытывает сомнение насчет качества выполненной услуги или профессиональных качеств исполнителей;

- · появилась потребность в том, чтобы повысить популярность и посещаемость сайта;

- страницы, входящие в состав сайте, не способны попасть в топ поисковых серверов, недостаточно хорошо индексируются;

- сайт не может выдержать конкуренции;

- оптимизированные страницы затруднительно обнаружить в результатах, которые выдаются поисковым сервисом;

- недостаточно высокая конверсия Интернет-портала;

- веб-специалист не может работать с ресурсом из-за обилия ошибок;

- собственник ресурса не может выделить бюджет на дорогостоящую рекламу;

- есть потребность в повышении рейтинга сайта;

- веб-специалисту в срочном порядке потребовались сведения о ресурсе.

Тем не менее, анализ контента сайта нужно выполнять для решения ряда целей:

- желание делать качественный контент профессионального уровня. Чтобы обрести такую возможность, требуется ознакомиться с материалами, которые предлагают конкурирующие предприятия, произвести их анализ, причем, чес больше, тем лучше;

- поиск уникального решения. Исследование материалов конкурентов может вывести на совершенно новые мысли. Их можно смело включать в уже существующий контент;

- сопоставление. При ознакомлении с контентом конкурирующего предприятия, появляется возможность узнать о его мнении насчет конкретных тем, обнаружить уникальное решение поставленной проблемы;

- пополнение контента. При исследовании контента конкурентом и просматривая чужой контент, появляется шанс сделать некоторые выводы, которые могут найти отражение на просторах другого Интернет-ресурса;

- дублирование. Многие виртуальные ресурсы готовы предложить материал, который просто был скопирован «от и до». Причем, иногда можно обнаружить ссылку на изначальный источник. Другие же разработчики не уделяют этому внимания, из-за чего могут возникнуть проблемы с законом. Именно по этой причине лучше не устанавливать какие-либо цели при проведении анализа контента.

Способы, применяемые при анализировании контента

На данный момент времени выделяется несколько методик, применяемых для выполнения анализа:

- качественное исследование. При использовании представленного метода появляется возможность узнать мнение пользователей, посещающих сайт, касательно его уровня. При этом важно выяснить такие параметры, как: качество информации, представленной на сайте; уровень подачи; степень соответствия ожиданиям со стороны посетителей;

- количественный анализ. Дает возможность выявить, какое воздействие на пользователя, заглянувшего на сайт, оказала информация, размещенная на страницах. Иногда выполняется расчет частотности ключевых слов и смысловых показателей, показывающих количество структурных единиц. Это нужно для понимания того, насколько хорошо Интернет-портал определяется поисковыми сервисами.

Степень восприятия информации находится в зависимости от многочисленных показателей, в том числе, от присутствия и плотности ключевых слов, объема информации в текстовой форме и так далее.

Базовые пункты анализа текстового контента

В этот список включаются:

- Объем. Наличие оригинального заполнения сайта позволяет индексировать страницы, это особенно актуально, если речь заходит о Яндексе. Чтобы сайт попал в индекс, на нем должен присутствовать текст, чей объем составляет не менее 500 знаков. Оптимальный вариант – текст объемом более 2000 символов. При размещении текста нужно обязательно принимать во внимание тип выделенного Интернет-ресурса. Если речь идет о виртуальном магазине, тогда текст товарной карточки должен состоять из 500 символов, для блогов же указанного объема недостаточно.

- Регулярность обновления. От того, как часто производится обновление контента, находится в зависимости степень доверия поисковиков к ресурсу. К примеру, если в виртуальном магазине обновление товарного ассортимента и увеличение контента происходит примерно раз в год, стоит ожидать, что с течением времени сайт утратит прежние позиции и трафик.

- Вхождение ключевых фраз. При проведении анализа, стоит уделить внимание данному фактору, имеющему значение. Он оказывает воздействие на ранжирование, выступает в качестве основы для определения степени соответствия ресурса запросам пользователей в поисковой системе. Эксперты рекомендуют не ограничиваться законом Ципфа, не доверять данным, утратившим актуальность. На одну тысячу символов лучше использовать не более 1-2 ключевых слов, размещая, в среднем по 3-4 штуки на одной странице. Это актуально, если объемы статей превышают 5 тысяч символов. Перед тем, как приступить к работе над информацией, стоит выполнить анализ виртуальных ресурсов, выдаваемых в ТОПе поисковой системы по конкретному запросу.

- Переспам ключевиков. Здесь несколько затруднительно говорить о каком-то конкретном показателе плотности, так как он находится в зависимости от темы сайта. Тем не менее, эксперты говорят о том, что плотность ключевых слов не должна быть более 5%. Если одно ключевое слово или фраза были внедрены по 10 и более раз, а положение страницы в поисковом сервисе так и не изменилось, вероятно, это связано с избыточной оптимизацией страницы, и попадание под фильтр. Иногда специалисты сталкиваются со страницами, где применяется более двух десятков ключевиков. Если принять во внимание мета-теги и alt/title, то число включений достигало 30 штук. Это уже может расцениваться как переспам ключевых слов. Анализ страницы на ключевые слова поможет решить эту проблему.

- Применение форматирования не по назначению (это актуально для таких тегов, как: b, strong, i). Было время, когда веб-мастера выделяли ключевые слова или фразы курсивом, или полужирным начертанием. Этот метод оказывал положительное влияние на ранжирование страницы. Однако, после того, как было проведено совершенствование поисковых алгоритмов, данный способ утратил прежнюю актуальность. Здесь есть еще важный момент: прогрессивные специалисты отказываются от каких-либо выделений, однако, это тоже не совсем правильно. Обычно выделение используется тогда, когда требуется привлечь внимание пользователей, посетивших ресурс, к какой-либо фразе или же подчеркнуть наиболее важную мысль. Но злоупотреблять тегами для выделения все равно не стоит.

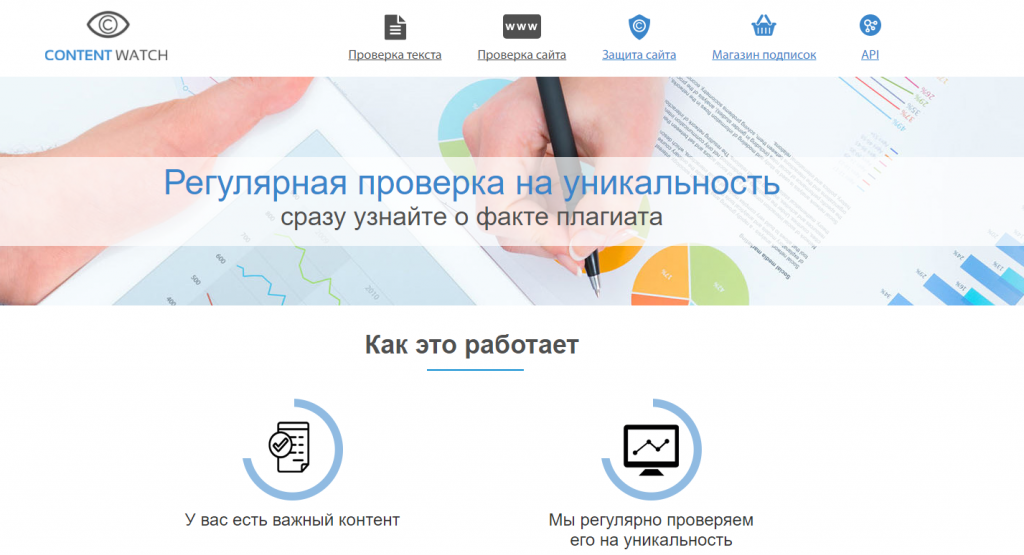

- Уникальность текстовой информации. При выполнении анализа контента, следует уделить внимание уникальности. При самостоятельном создании теста нельзя на сто процентов быть уверенным в его оригинальности. Нельзя забывать и о том, что существует воровство контента, которое встречается не так редко. Если конкурирующая фирма прочитает статью, и она ей понравится, то они могут совершенно спокойно копировать ее, чтобы использовать для заполнения своей страницы. Если их ресурс функционирует дольше, велика вероятность того, что поисковые системы отдадут предпочтение именно ему. При этом текст на странице, где он был размещен изначально, посчитают плагиатом и не будут индексировать. На сегодняшний день существует множество методов, за счет которых можно осуществлять проверку текстов. Один из наиболее распространенных варрантов – это CONTENT-WATCH, который советуют профессионалы.

- Уникальность графического материала. Большое значение для трафика из поискового сервиса имеет информация в графическом виде. Наиболее популярные сервисы, предназначенные для поиска в Сети, индексируют и выдают в ТОП те Интернет-ресурсы, которые содержат оригинальные материалы. Это дает возможность пользователям, заинтересовавшимся вашими материалами, переходить на необходимую страницу прямо из результатов поиска по картинкам. Чтобы воспользоваться представленным приемом, требуется размещать только оригинальный контент. Для проверки степени уникальности картинок существует сервис «TinEye».

- Структура контента. Основные требования, которые предъявляются к структуре: четкость, легкость восприятия. Недопустимо, чтобы текст был представлен единым полотном. Важно включать списки и сноски, делить текстовую информацию на абзацы и разделы, снабженные заголовками. Если не позаботиться об этом, велик риск того, что сайт попадет под санкции со стороны поискового сервиса. Наличие других очевидных ошибок может только усугубить ситуацию.

- Ошибки, допущенные в текстовых фрагментах. Довольно часто недостаточно опытные веб-мастера самостоятельно делают тексты для заполнения Интернет-ресурсов, однако, они могут допускать серьезные недочеты. С другой стороны, профессиональные копирайтер также не всегда способен предоставить материал, отличающийся высоким качеством. Конечно, совершенные ошибки не могут не повлиять на состояние ресурса. Исправление текстовых ошибок – это работа для корректоров. Они способны выполнить анализ контента, выявить существующие орфографические, а также синтаксические ошибки.

- Избыток мета-тегов – это одна из наиболее распространенных ошибок. Нужно отнестись к проблеме с особым вниманием. Довольно часто встречаются тексты, где есть множество мета-тегов, включающих ключи, вставленные в качестве перечисления, разделенные только запятыми. Это совершенно недопустимо. Суть таких тегов, как title и description заключается в смысловом раскрытием Интернет-страницы в качестве обобщённых сведений, представленных там. Важно, чтобы Мета-теги были читаемыми. Для того чтобы произвести их проверку, рекомендуется использовать Screaming Frog.

- Дубляж мета-тегов. Проблема актуальна для многих порталов, вне зависимости от степени их популярностью. Обычно с ней сталкиваются на Интернет-страницах с параметрами GET и пагинации. Такая проблема может быть решена за счет классических сервисов URL и robots.txt. Если при анализировании контента были обнаружены определенные электронные страницы с дублями, то их будет достаточно заменить на уникальные, чтобы решить вопрос.

- Заголовки H1. Это наиболее грубая ошибка, которая включается в категорию «технических». Увы, на сегодняшний день она очень часто встречается. Суть заключается в том, что на одной странице располагается несколько заголовков первого уровня. Это может повлечь за собой санкции со стороны поискового сервиса. А потому не стоит забывать о том, что на одной странице должен быть только один заголовок Н1.

- Заголовки H2-H3. Такие заголовки не имеют особого значения для SEO портала, однако, они принимаются во внимание при некоторой релевантности виртуального ресурса. Иногда можно встретить сайты, которые содержат недозволительно много заголовков. Это очень большой недочет, который нужно исправлять. При формировании контента, не рекомендуется впадать в фанатизм: вполне достаточно 5 заголовков Н2, Н3. Конечно, можно добавлять больше, главное, не перестараться. Также важно проследить за тем, чтобы они не были включены в заголовок сайта и в навигационную систему.

- Длина заголовков H1-H6. Не существует определенных указаний на этот счет. Однако, эксперты предполагают, что любые заголовки способны оказать негативное влияние на ранжирование, если включают несколько предложений. В некоторых случаях по размерам их можно сравнить с целым абзацем. Лучше использовать лаконичные заголовки, содержащие основную информацию. Нежелательно, чтобы их длина была более пары строк. Не стоит забывать о том, что заголовки нужны для того, чтобы привлекать внимание пользователей, посетивших сайт. Важно, чтобы при первом же осмотре он понял: это то, что ему будет полезно.

- Применение в теге title ключевых слов/фраз. Такой заголовок значится при определении релевантности веб-страницы запросу, заданному в поисковой системе. Именно по этой причине при выполнении анализа контента сайта, данному пункту стоит уделить пристальное внимание. Желательно, чтобы заголовок title включал ключевое слово или фразу.

- Наличие атрибутов «alt» и «title» для графического материала. Первый из перечисленных атрибутов может быть полезен, если пользователь не в состоянии рассмотреть изображения. При этом title возникает за счет наведения курсора на картинку, по сути, это и есть ее наименование. В перечисленных атрибутах следует прописать релевантный (то есть, основной) ключ страницы, что позволит существенно поднять релевантность по запросу в поисковой системе. Рекомендуется следить за тем, чтобы число ключей соответствовало числу изображений, однако, не стоит усердствовать, чтобы не получить переспам.

- Релевантность тега «title» к контенту. Нельзя забывать о том, что этот тэг оказывает воздействие на релевантность сайта, следовательно, важно, чтобы он отражал суть содержимого Интернет-портала. К, примеру, title содержит данные насчет цен, скидок, бесплатной доставки, при этом сам контент не включает перечисленные обстоятельства. В таком случае велик риск потерять потенциальных клиентов, а также снизить позиции в поисковой выдаче.

Софт и сервисы для анализа уникальности контента

Специалисты рекомендуют следующие варианты:

Advego – сервис анализа сайтов, который появился одним из первых, однако, до сих пор не утрачивает лидирующих позиций. В основе алгоритмов заложен метод шинглов. Это означает, что проверка сайта на уникальность производится за счет разделения текстового поля на отдельные фрагменты и проведения сверки с аналогичными фразами, выложенными в Интернете. Здесь многие важные параметры присутствуют по умолчанию, например, один шингл равен четырем словам. При желании можно изменить указанные параметры, допустим, установить меньшее число слов. Однако, в таком случае в Интернете программа найдет большее количество совпадений, так как, вне зависимости от языкового разнообразия, значение имеет изобилие разнообразных текстов, представленных в Сети. Для начала работы потребуется установить свой собственный ключ для автоматического распознавания капчи. На это нужно потратить некоторое время, чтобы в дальнейшем пользоваться программой. RuCaptcha и Antigate (это популярные сервисы, которые могут легко справиться с поставленной задачей). Разумеется, не обязательно проводить установку распознавания капчи в автоматическом режиме, однако, это сделает работу намного легче, так как при проверке больших объемов текста не потребуется отвлекаться на введение вручную.

При проверке текстов, написанных на русском языке, нужно указывать в меню настроек те поисковые сервисы, которые предполагается использовать. Если же текст сделан на английском языке, лучше задействовать в работе все предлагаемые варианты.

Софт допускается применять еще и затем, чтобы проанализировать контент сайта на рерайт, потому что он позволяет с легкостью определять тексты с идентичной семантической структурой за счет выполнения эвристического анализа. Итоговые сведения представляются в виде пары чисел, первое из которых – доля уникального текста; второе - доля уникального контента.

Получается, что Адвего способен распознавать оригинальный контент, по отношению к которому был сделан грамотный рерайтинг, а также уникализированный текст, то есть, текст, где автор внес небольшие изменения в структуру предложений, подобрал подходящие синонимы.

Основные преимущества:

Основные недостатки:

- алгоритм шинглов уже успел устареть, несмотря на то, что он подвергался модернизации за счет добавления эвристического анализа;

- итоги выполненной проверки не в каждом случае соответствуют действительности. Бывают случаи, когда выдается совпадение с текстами, которые не имеют ничего общего с текстами, по отношению к которым проводился анализ.

Программа eTXT - сервис анализа сайта на уникальность. Данный софт обретает популярность, и на сегодняшний день уступает разве только что варианту, описанному выше. Это можно объяснить следующим обстоятельством: функциональный ассортимент здесь шире, чем у Адвего.

Как и в предыдущем случае, при проверке применяется метод шинглов с добавленным эвристическим анализом, который требуется для проведения проверки на рерайт. Отличие от Адвего заключается в том, что каждая проверка контента делается по отдельности, то есть, пользователю нужно выбрать нужные функции, воспользовавшись меню.

Разумеется, софт предусмотрел настройки по умолчанию. Алгоритм eTXT имеет ряд отличий, если проводить сравнение с Адвего, вероятно, именно по этой причине длина шингла здесь составляет 3 слова. Менять данный параметр не рекомендуется.

Программа дает возможность корректировать настройки. К примеру, можно подобрать оптимальный сервис капчи (на выбор предлагается 5 вариантов). У пользователя есть шанс настроить интерфейс, в том числе, поменять шрифт.

Функционал программы дает возможность осуществлять анализ контента Интернет-портала при помощи разнообразных методов: пакетная проверка, полная проверка уникальности Интернет-портала, сопоставительный анализ нескольких текстов.

Если вы воспользуетесь таким пунктом в меню, как «Операции – Пакетная проверка», то сумеете провести проверку текстов, находящихся в отдельной папке.

За счет пункта в меню «Операции – Сравнение текстов» появляется возможность сопоставить пару текстов. Для этого в окно, располагающееся в левой части, вставляется исходный текст, а в окно, которое находится в правой части – версия, прошедшая рерайт. Весьма удобный вариант для людей, работающих с одним из текстов вручную.

Каковы преимущества:

- обширный функционал;

- отсутствие ограничений по отношению к настройкам различных параметров (это касается как интерфейса, так и проверки);

- популярность, которая является подтверждением хорошей работы программы;

- оперативность проверки, которая зависит только от скорости подключения к Сети.

Каковы недостатки:

- применяется устаревший метод шинглов;

- проверка выполняется довольно долго, именно поэтому возникают затруднения при проверке больших текстов.

Сontent-Watch - данный сервис не предполагает использования метода шинглов, он основывается на эвристическом анализе. Здесь можно сделать анализ контента отдельной электронной страницы сайта или всего Интернет-ресурса в режиме реального времени. Для этого достаточно настроить автоматическую проверку, что не вызывает затруднений: нужно указать адрес сайта (или нескольких электронных страниц), при этом сервис будет с заданной периодичность производить проверку. При обнаружении дублей сервис отправляет собственникам Интернет-порталов сообщение о том, что от них требуется размещения обратной ссылки, которая направляет пользователей на ресурс с исходным материалом. Такой функции на других сервисах найти просто невозможно.

Программа функционирует в 2-х режимах. Первый – ознакомительном, второй - полнофункциональный. Первый из указанных режимов дает возможность производить проверку нескольких страниц в сутки. Чтобы узнать обо всех существующих возможностях ресурса, требуется пройти процедуру регистрации. Тем пользователям, которые успешно зарегистрировались, предоставляется шанс воспользоваться всем функционалом и производить проверки больших текстов. Для сравнения: вручную можно проверить около 20 текстов объемом около 10 тысяч символов каждый, а в автоматическом – 40 текстов идентичного формата. Если объем текста выходит за указанные рамки, стоит воспользоваться платными услугами, подобрав подходящий вариант.

Преимущества:

- анализ контента выполняется довольно быстро;

- при необходимости можно провести проверку всего сайта;

- наличие пакетной проверки;

- применение эвристического способа;

- возможность осуществлять контроль над контентом, представленном на сайте, чтобы с заданной периодичность искать дубли в Интернете. Для это достаточно настроить автоматическую проверку.

Недостатки:

- отсутствие возможности оценить качество проверки из-за закрытого алгоритма;

- лимитированные возможности функционала, предоставляющегося бесплатно;

- низкая популярность.

Copylancer - функционал данного сервиса характеризуется добротностью, так как предоставляет специалистам по копирайту возможность выполнять проверку уникальности текста, а также осуществлять семантический анализ контента.

Сложно с точностью сказать, какой алгоритм применяется при работе программы. Однако, если учесть все отзывы и практический опыт, можно сделать вывод о том, что в основе заложен эвристический анализ, ищущий синтаксические совпадения.

Анализ выполняется за счет выполнения простых действий: пользователю нужно вставить в предложенную форму текст, а после кликнуть по кнопке «Проверить». Потребуется подождать всего несколько секунд, чтобы увидеть готовый результат. Если нужны адреса Интернет-порталов, с чьим контентом были найдены совпадения, об этом можно получить информацию, если воспользоваться меню. Нужно выбрать «Проверить URL», а после вставить ссылку, которая интересует пользователя.

Также, используя меню, можно перейти во вкладку «Анализ текста». Здесь, вставив в предложенное поле свой контент, можно выполнить СЕО-анализ. Требуется нажать кнопку «Проверить» и выждать несколько секунд, чтобы просмотреть итог по следующим параметрам: числу слов и символов (с пробелами и без пробелов), по тошноте (в %). Также предлагают статистические данные касательно вхождения каждого отдельного взятого слова и фразы, включающей по 2-3 слова.

Преимущества:

- высокая скорость работы;

- применение эвристического способа для анализа синтаксиса;

- наличие возможности выполнить СЕО-анализ.

Недостатки:

- наличие алгоритмов, недоступных для пользователя;

- отсутствие пакетной проверки, что означает, что работу придется выполнять вручную;

- сравнительно низкая популярность.

Text.ru - этот сайт позволяет выполнить стандартную проверку. Для этого нужно вставить текст в предложенную форму, которая находится на главной странице, а после кликнуть по кнопке «Проверить на уникальность». Потребуется некоторое время, чтобы работа была завершена, а результаты – представлены пользователю в виде трех вкладок:

- уникальность. Неуникальные фрагменты подсвечиваются, также перечисляются сайты, где представлена оригинальная информация;

- орфография. Разумеется, уровень представленного сервиса несколько ниже, чем у сайтов, которые специализируются на обнаружении орфографических ошибок. Можно кликнуть по вкладке, чтобы выявленные ошибки были подсвечены;

- семантический анализ. В этой вкладке представлена информация насчет степени заспамленности текста, а также количестве воды и вхождений слов. Слова, влияющие на повышение заспамленности, подсвечиваются фиолетовым цветом, степень насыщенности обозначает частотность вхождений того или иного слова.

За счет грамотного использования данного ресурса специалисты обретают возможность обрабатывать текст выборочно, например, убирая лишнее. Следовательно, выполняется не просто анализ контента, но и оптимизация. Пользователям предлагается воспользоваться вспомогательными функциями:

- пакетная проверка текстов, что означает следующее: предусмотрена возможность параллельно загрузить на сайт несколько документов, то есть, пакет, а после автоматически проверить их на уникальность. Внутренняя сортировка сделана так, чтобы тексты находились так, как удобно пользователю. С другой стороны, сервис способен распознать почти все существующие форматы текстов. Для выполнения проверки пакета, нет никакой необходимости тратить время на ожидание в очереди. А потому данный сервис отлично подходит для людей, ценящих свое время и силы. Достаточно загрузить текст, а после дождаться результатов;

- регулярно выполняемая проверка. Для контроля над состоянием контента и обеспечения его защиты от нелегального применения, можно задействовать функцию «Регулярная проверка». Как это сделать? Сначала нужно загрузить текстовые документы, а после подключить регулярную проверку. Важно указать ссылки на собственный Интернет-ресурс или же определенные страницы, для которых нужна проверка, осуществляемая регулярно.

Использовать представленный сервис довольно удобно и не слишком затратно. Настройки отличаются гибкостью, следовательно, человек может устанавливать периодичность проведения проверки. Ручная проверка предлагается совершенно бесплатно и в любой момент времени. За услуги, которые предоставляет сайт, нужно платить. На выбор предлагается несколько доступных вариантов, например, можно приобрести PRO-аккаунт или выбрать пакеты на проверку текстов.

Основные преимущества:

- сервис занимает топовые позиции в выделенной сфере, пользуется большой популярностью среди пользователей;

- наличие прогрессивной системы для проведения эвристического анализа;

- обширный список вспомогательных услуг;

- широкий функционал, предназначенный для защиты и контроля.

Основные недостатки:

- отсутствие доступа к алгоритму проверки;

- дополнительный функционал открывается только тем, кто за него заплатил;

- чтобы провести проверку бесплатно, нужно провести некоторое время в ожидании своей очереди;

- из-за повышенных нагрузок сервис нередко дает сбои, из-за чего работа прекращается.

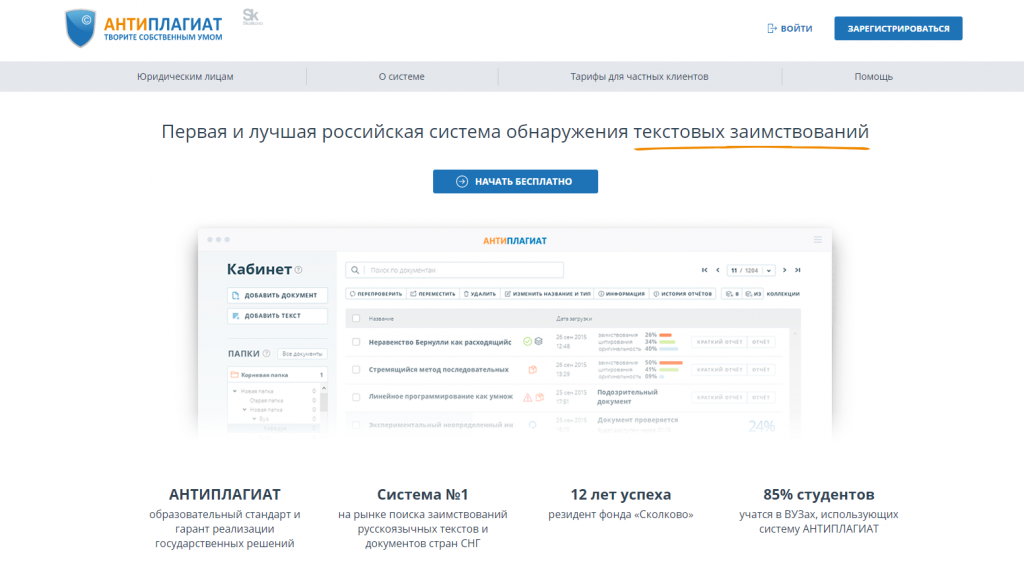

Антиплагиат - это сервис, отличающийся долгим сроком существования. Изначально его создавали, чтобы получить возможность проверять работы студентов, чтобы выявлять, не были ли они скачаны из Интернета. Сейчас же он используется и для других целей. Этот вариант достаточно удобен в использовании и прост в освоении, что можно назвать одним из основных его преимуществ. Чтобы произвести проверку, пользователю нужно всего лишь перенести в выделенное поле текст (важно, чтобы его объем не превышал 5 тысяч символов), а после, кликнуть по кнопке «Проверить». Чтобы проверить более крупный текстовый фрагмент, нужно пройти регистрацию (это не займет много времени). Еще один важный плюс сервиса – возможность произвести проверку, не загружая текст в Интернет. Важно, чтобы персональный компьютер был подсоединен к Сети.

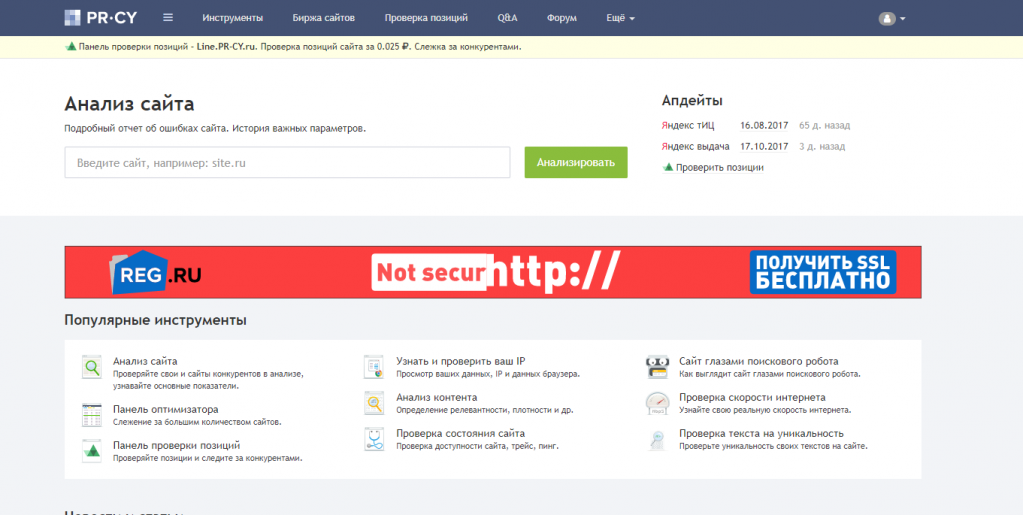

Pr-cy - сервис довольно прост в использовании: в поле, представленное на странице, нужно вставить текст и дождаться результата. Анализ происходит в режиме реального времени. Система оперативно находит страницы, где есть либо частичное, либо полное совпадение текстовых фрагментов, подвергаемых проверке. Результат демонстрируется в процентах, это дает возможность оценить качество деятельности специалиста по копирайту, сделать выводы подготовки контента к дальнейшему размещению в Интернете. Чтобы произвести проверку, текст разделяется на несколько частей, по отношению к которым выполняется поиск аналогов. Если система выискивает фрагмент, который идентичен проверяемому тексту, тогда процент результативности сокращается. Если же текст был создан самостоятельно, то процент уникальности будет составлять не меньше 90%. Если текст был скачан/скопирован, то высокого показателя система точно не покажет.

Сценарии и план анализа контента с собственного портала

Если анализ контента сводится к проверке 10 статей, входящих в состав блога, тогда совершенно не обязательно составлять план. Важно лишь внимательно изучить все материалы, посетить Google Analytics, подумать над тем, как усовершенствовать те статьи, которые уже есть в наличии или те, что готовятся к публикации.

В том случае, если на Интернет-ресурсе уже содержится довольно большой объем материалов, тогда не обойтись без плана. Важно продумать, в какой последовательности производить проверку, какие инструменты будет удобнее применять с целью оценки портала.

Существует классический план, применяемый при проведении анализа контента портала, где содержится большой объем информации. Разумеется, в него можно вносить свои коррективы. Однако, при этом нельзя забывать о том, что при анализе ресурса нужно решать ряд задач. В их список включаются:

- фиксация в таблице все единые указатели ресурса, приводящие на сайты с конкретными данными;

- выполнение анализа эффективности электронных страниц за счет использования специальных инструментов;

- выполнение анализа контента. Если сайт включает в себя от тысячи страниц, то вручную проанализировать можно только отдельные фрагменты, например, некоторые статьи, отличающиеся наибольшей эффективностью;

- определить контент, который требуется добавить;

- составить описание ситуации, чтобы сформулировать рекомендации по ее совершенствованию. Говоря другими словами, важно проработать оптимальный вид стратегии. При регулярном выполнении аудита контента, стоит использовать специальную таблицу, где представлены разнообразные сценарии. Ее применение позволит выполнить анализ контента сайта, обратив внимание на наиболее значимые моменты.

- в браузере Google Chrome найти инструменты, предназначенные для web-мастеров, выбирать меню «Поисковый трафик – запросы» и перейти во вкладку под названием «Популярные страницы»;

- выбрать для выполнения анализа наиболее обширный диапазон дат, установить его;

- войти в меню «Показать строки», выбрать «500» (это наибольший показатель), кликнуть по адресной строке программы, предназначенной для просмотра Интернет-страниц. Там возникнет единый адрес страницы, который заканчивается комбинацией символов «s=500». Достаточно изменить последний символ на цифру, показанную в инструментах для специалистов;

- кликнуть «Ввод», чтобы увидеть многочисленные адреса;

- открыть JavaScript в браузере Google Chrome;

- перенести в поле специальный код и нажать на клавишу Enter. Выполнение этих нехитрых действий позволит просмотреть ключевые слова для каждого электронного ресурса. В дальнейшем на мониторе можно увидеть диалоговое окно, где предлагается перевести информацию в текстовую форму, чтобы обеспечить сохранность;

- переключить вкладку «Актуальные запросы»;

- войти в меню «Показать строки», выбрать максимальное значение.

- выбрать в планировщике пункт под заглавием «Получить статистику запросов для перечня ключей или сгруппировать объявления»;

- вставить перечень ключей, составленный заранее (эта работа выполняется на предыдущем этапе);

- кликнуть по кнопке «Узнать число запросов». Здесь важно учесть, что формат планировщика способен допустить не более тысячи ключей. Однако, при желании можно задействовать формат CSV, который позволяет увеличить количество ключей до 3-х тысяч.;

- вставить в проект слова, произвести загрузку.

- страницы с повышенным уровнем риска нужно проверять особенно внимательно. Специалисты говорят о том, что следует действовать таким образом: обновить контент, убрать те страницы, которые содержат скопированные материалы или же информацию, не вызывающую у посетителей никакого интереса;

- исследование нужно проводить как над популярными, так и не популярными страницами, не делая исключений. Очень важно заняться совершенствованием публикаций, располагающихся на тех страницах, которые получают наибольший трафику, однако, демонстрирующих недостаточно удовлетворительные метрики. Также важно убрать страницы, совершенно не приносящие трафика, не вызывающих интереса у публики, посещающей сайт;

- недопустимо, чтобы система управления содержимым страницы сохраняла итоги поиска по Интернет-ресурсу. Если это случается, нужно браться за удаление.

- ключевые слова/фразы, стимулирующие ранжирование сайта. Анализ ключевых слов сайта онлайн здесь проводится довольно быстро;

- итоги распределения в топовой выдаче;

- наличие/отсутствие приложений, подходящих для мобильных устройств;

- основные конкуренты;

- ссылки;

- наличие/отсутствие видеоматериалов и медийной рекламы.

- определенных запросов;

- объявлений (точнее, их позиций и тестовых фрагментов);

- информация касательно трафика;

- сведения о бюджете;

- информация о запросах, оставляемых в поисковой системе;

- данные о позициях в поисковых сервисах;

- фрагменты оригинальных тестов и указателях страниц;

- изменение позиций с течением времени.

- выполнение анализа запросов, способных вывести портал в итоги поиска;

- представлять Интернет-портал в поисковом сервисе, предоставляя информацию о происходящей динамике;

- демонстрация тех страниц, которые имеют наибольшую значимость (если рассматривать их с позиции видимости сервисами для поиска в Интернете);

- распределение ключевиков по позициям;

- демонстрация ресурсов, выступающих в качестве основных конкурентов;

- сравнение доменных имен.

- сведения о степени видимости доменного имени в поисковых сервисах;

- информацию об органике и по контексту;

- список Инернет-ресурсов, выступающих в качестве основных конкурентов;

- позиции ключевых запросов;

- сопоставление доменных имен по нескольким параметрам: позициям и ключевым словам/фразам.

- по Интернет-ресурсам. Сервис составит список тех сайтов, чья реклама появляется в результате поиска по конкретным запросам, внесенным в поисковую систему;

- по запросам: продемонстрирует запросы, после введения которых в поле поискового сервиса возникают рекламные материалы некоторых Интернет-порталов.

Основные стадии анализа контента

Допустим, нужно проанализировать контент сайта, принадлежащего виртуальному магазину. При этом объем ресурса равен восьми сотням индексированных страниц. Туда включаются: страницы с продукцией и ее описанием, разделение товаров по отдельных группам, блог, где размещаются тематические сведения.

Если вы выступаете в качестве собственника Интернет-ресурса, и при этом догадываетесь (хотя и не испытываете уверенности), что относительно выделенного сайта поисковые системы ввели санкции из-за проблем с контентом, это может быть: слишком низкое качество, малый объем, несоответствие актуальным направлениям, копирование информации.

Первая стадия: анализ сложившееся ситуации, составление сценария анализа, который будет проведен над контентом. Каждый проект должен рассматриваться в индивидуальном порядке. Тем не менее, в любой ситуации нужно выделить базовый алгоритм действий. Это необходимо для того, чтобы проанализировать объем сайта и выделить возможный угрозы санкций со стороны поисковых систем. Говоря другими словами, нужен анализ основных параметров Интернет-портала.

Ресурс достаточно большой, а потому сконцентрироваться на совершенствовании каждой из страниц просто не представляется возможным. Однако, надо разработать план, а после, оперативно работать по нему.

Если же Интернет-ресурсу угрожают какие-либо алгоритмические санкции (к примеру, Panda), которые используются при некоторых проблемах с контентом, тогда лучше следовать простейшему сценарию. Он предполагает обновление материалов или устранение страниц, утративших актуальность.

Если принять во внимание объем Интернет-ресурса, то лучше сконцентрировать внимание на обнаружении и устранении контента, не отличающегося достойным качеством. Также нужно позаботиться об удалении страниц, переставших быть актуальными. С другой стороны, требуется выделить ключевые страницы портала, побеспокоиться насчет их модернизации.

В большинстве случаев анализ контента не может обойтись без изучения ключевых слов. После выполнения данной процедуры нужно сделать вывод насчет того, удовлетворяют ли ключевые страницы сайта запросам со стороны пользователей. Также важно выяснить качество контента, размещенного на этих страницах.

Если виртуальный магазин не затронули алгоритмические санкции, тогда страницы по-прежнему будут индексироваться. В таком случае главной задачей остается заполнение электронных страниц материалов, например, продаваемой продукцией и ее описанием. При желании нужную информацию можно взять с Интернет-ресурсов спецификации.

Вне зависимости от ситуации, на тех страницах, которые считаются наиболее популярными, нужно разместить описание, отличающееся достойным качеством. Также важно внести в проект пункт по составлению описаний для всех типов продукции, которые предлагаются в продажу на сайте.

Вторая стадия включает в себя сканирование сайта. На этом этапе нужно получить полный перечень указателей ресурса. Чтобы как можно скорее решить данную задачу, рекомендуется применять специальные инструменты, в том числе: Screaming Frog и XML-sitemaps.com. Интернет-портал, содержащий не более пяти сотен страниц, сканируется через указанные сервисы совершенно бесплатно.

Следовательно, при грамотном использовании инструментов, пользователь получает весь список, не тратя время на установку программы на персональный компьютер. Анализ контента выполняется довольно легко: достаточно посетить ресурс, ввести нужный адрес, кликнуть по кнопке «Start».

Если требуется произвести проверку достаточно большого сайта, будет удобнее проводить сканирование при наличии платной версии сервиса. После завершения работы, достаточно скачать полный список, где будут представлены единые указатели ресурса. Для ознакомления с документом рекомендуется использовать подходящий табличный редактор. Это может быть: MS Excel или LibreOffice Calc.

Третья стадия - проверка эффективности контента. Чтобы проанализировать контент с позиции его эффективности, рекомендуется использовать сразу несколько программ/сервисов. К примеру, можно применить такой вариант, как URL Profiler. За весьма ограниченный временной промежуток он способен провести исследование множества виртуальных страниц. Чтобы воспользоваться данным инструментом, нужно запустить программа и перенести в нее список единых указателей ресурса, который был составлен заранее. Далее все решают задачи, стоящие перед исполнителем, а также выбранные аналитические сервисы. Отталкиваясь от этих параметров, следует подобрать оптимальные опции для анализа.

Для быстрого ознакомления с итогами выполненного анализа требуется проследить путь их сохранения. Для этого нужно кликнуть по кнопке «Run Profiler», переслать нужную информацию в специальную таблицу, куда вносятся результаты аудита контента.

Сведения, которые были получены благодаря выполненной проверке, нередко применяются с целью определения эффективности электронных страниц. Выборочный анализ контента поможет решить поставленную задачу. После этого можно составить дельные рекомендации по работе с контентом для отдельных страниц, не отличающихся высокой степенью эффективности.

К примеру, если работать по сценарию, описанному выше, можно выполнить полное удаление страницы/контента или же заняться совершенствованием и оптимизацией материалов.

Четвертая стадия – внесение сведений о ключевых словах/фразах. Представленный сценарий анализа предполагает создание карты ключевых слов/фраз для страниц, считающихся наиболее значимыми. Для решения поставленной задачи рекомендуется использовать подходящие инструменты, предназначенные поисковой системой для Google специально для веб-мастеров. Они позволяют подготовить выборку наиболее популярных запросов на виртуальных страницах, выходящих в ТОП.

При введении информации, нужно работать по предложенному алгоритму:

Если действовать по рекомендациям, представленным выше, то все запросы, пользующиеся популярностью, будут представлены на одной странице, что очень удобно. Достаточно загрузить таблицу в формате CSV, чтобы изучить результаты исследования.

Пятая стадия предполагает изучение ключевиков. Исследование контента сайта не может считаться полноценным, если не было проведено изучение ключевых слов/фраз. Для выполнения этой работы можно использовать разнообразные планировщики ключей. Большой популярностью пользуется инструмент от Google. Чтобы его использовать, нужно следовать предложенному алгоритму:

Шестая стадия – это интеграция информации по ключевикам. Планировщик позволит пользователю получить ключевые фразы, узнать количество запросов, информацию о конкуренции. Инструменты для специалистов дают возможность выяснить, данные об электронных страницах, из актуальной позиции, количестве просмотров и так далее. Полученные данные нужно перенести в табличный редактор, чтобы наглядно представить все имеющиеся показатели.

Информацию можно использовать в процессе создания карты ключевых слов/фраз для тех страниц, которые отличаются наибольшей значимостью. Для этого нужно самостоятельно проанализировать контент определенной электронной страницы, проверить степень соответствия запросам в поисковом сервисе, а также уровень публикаций. После завершения этой работы можно смело записывать рекомендации, которые будут полезны при разработке контента. Их нужно занести в таблицу.

Седьмая стадия – это определение, какого контента не хватает на выделенном сайте. Этот этап не включается в стандартный сценарий, потому что необходим при работе с объемными Интернет-порталами, где возникает потребность в улучшении контента и устранении материалов, утративших прежнюю актуальность. При работе с ключевиками нередко можно получить вспомогательные ключи, имеющие большую важность. Они оказывают воздействие на ранжирование некоторых страниц. Перечисленные ключевики следует внести в таблицу, чтобы в дальнейшем сформировать контент, который сможет полностью отвечать запросам в поисковых системах.

Восьмой этап - анализ дополнительных параметров виртуальных страниц. При выполнении анализа контента за счет использования URL Profiler, можно получить данные, которые удобно применять для оценки эффективности страниц и поиска подходящих тактических приемов. При выполнении данной работы важно не упустить несколько моментов, представляющих особенную важность:

Девятая стадия – это составление рекомендаций по дальнейшей работе с Интернет-порталом. Таблица, куда были занесены итоги выполненного анализа почти завершена. Осталось занести в нее только рекомендации, составленные после выполнения работы. При оформлении отчета о выполненной проверке нужно перечислить в нем обобщенные впечатления, стратегию и тактику последующей работы с информацией, представленной на определенном ресурсе.

Инструменты, подходящие для анализа контента сайтов конкурирующих предприятий

Анализ текста сайта, принадлежащего конкурирующему предприятию, можно выполнить, использовав такие сервисы, как:

SEMrush - позволяет провести анализ сайтов конкурирующих фирм, а также проверить источники трафика и ключевые слова/фразы, за счет которых другой ресурс успешно продвигается в поисковом сервисе. Отчеты, полученные после проверки, отличаются объемом и содержательностью. В них перечисляется наиболее важная информация, представляющая интерес:

Этот сервис для анализа сайта – платный, за месяц его использования нужно платить сумму от 10 долларов и выше.

SpyWords - применяется, чтобы сделать анализ продвижения конкурирующих сайтов в поисковых сервисах и изучения контекстных кампаний. В данном случае проводится исследование следующих параметров:

Как провести анализ сайта? Довольно просто, однако, за это требуется внести оплату. Каждый месяц придется выделять на эти цели от 1950 рублей.

Serpstat - с помощью данного сервиса можно проанализировать контент, представленный на сайте конкурентов с позиции применения контекстных видов рекламы и выявления их места в итогах, выданных поисковым сервисом.

Serpstat предоставляет ряд важных возможностей:

Автоматический анализ сайта при помощи этого сервиса будет обходиться в сумма от 19 долларов в месяц и выше.

AdVodka - позволяет выполнять анализ контента Интернет-ресурса с позиции его включения в топовую двадцатку результатов, выдаваемых наиболее распространенными поисковыми сервисами. Однако, здесь принимается во внимание не только выдача по запросам (говоря другими словами, органическую выдачу), но еще и блоки с контекстными рекламными материалами. Важно не забывать о том, что сервисом могут воспользоваться только те люди, которые располагаются в Московской и Ленинградской областях.

Если же пользователь располагается в указанных локациях, тогда он может получить те услуги, которые предоставляет AdVodka, а именно:

Чтобы получить доступ, к перечисленным услугам, потребуется за каждый месяц выплачивать от 980 рублей.

aTrends - позволяет выполнять комплексный анализ Интернет-ресурсов, принадлежащих конкурентам. Все это выполняется через систему Яндекс.Директ. Анализ делается по нескольким параметрам: по объявлениям, доменам, ключевым словам/фразам.

Чтобы воспользоваться помощью сервиса, достаточно один раз в 3 месяца внести сумму, начинающуюся от 970 рублей.

ADVSE - такой сервис удобен тем, что способен формировать отчет по следующим показателям:

Для использования сайта нужно раз в год перевести сумму, начинающуюся от полутора тысяч рублей.

Как часто выполнять анализ контента страницы?

После оценки позитивного воздействия общего анализа Интернет-ресурса или определенной страницы (материала), можно с легкостью объяснить, почему подобные услуги пользуются повышенной популярностью. Вполне естественно, что анализ контента сайта онлайн нужен всем виртуальным ресурсам, без исключения, если они планируют развиваться и привлекать внимание пользователей Сети.

Вполне возможно, что анализа будет недостаточно. Если в процессе исследования были выявлены какие-либо проблемы, то их нужно устранить в кратчайшие сроки. Также важно поддерживать актуальность и качество материалов, публикуемых на сайте. Регулярность проверочных мероприятий выбирается владельцев. Проверка сайта на оптимизацию может осуществляться раз в 6 месяцев или раз в год.

В виртуальном мире нередко происходят какие-либо изменения. Поэтому, если сайт на сегодняшний день находится в топовой десятке по итогам запросов в поисковых сервисах, не стоит останавливаться. Велика вероятность, что уже завтра ситуация кардинально переменится. Разумеется, не все зависит только от собственника сайта, так как большое влияние оказывают и другие факторы. Они нередко оказывают усиленное воздействие на алгоритмы поисковых систем, применение новых фильтрационных систем и так далее.

А потому важно подготовиться к такому повороту событий. Для этого нужно получить как можно больше сведений насчет контента сайта. Конечно, проверка сайта на уникальность контента и другие показатели – довольно трудоемкий процесс. Для его осуществления нужно использовать профессиональные навыки. Если вы ими не обладаете, будет лучше обратиться к настоящим специалистам своего дела.